Arm, 모바일에서도 콘솔급 화질 구현, GPU 신기술로 성능 한계 넘어

엔씨소프트, 실시간 음성 AI, 캐릭터와 이용자 상호작용을 정교하게

화면과 소리 함께 진화, AI 기반 차세대 콘텐츠 제작 환경

[애플경제 김예지 기자] AI 기술이 화질과 음성기술을 동시에 발전시키며 콘텐츠 경험의 범위를 넓히고 있다. 모바일에서도 콘솔 수준의 화질이 구현 가능해졌다. 또한 음성 기술은 사용자의 목소리를 실시간으로 변환하거나 캐릭터 감정을 표현할 수 있는 단계에 이르렀다.

Arm과 엔씨소프트 등 테크 기업들은 최근 GPU 아키텍처와 음성 AI 기술을 공개하며, 모바일과 인터랙티브 콘텐츠 제작 환경에서 실제 적용 사례를 선보였다. 단순한 제작 보조를 넘어, 화면과 소리를 다루는 기본 구조 자체를 AI가 재설계하는 단계에 들어섰다.

모바일에서도 콘솔급 고화질 그래픽 구현 가능, Arm ‘NSS’ 공개

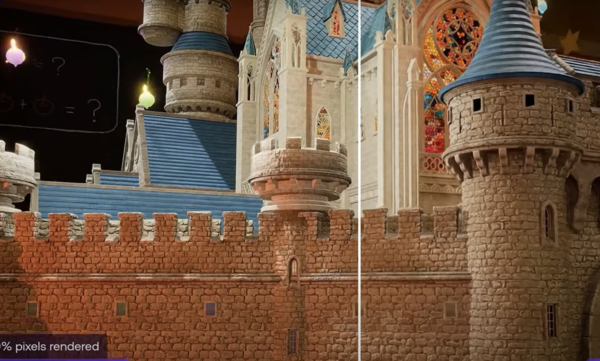

Arm은 모바일에서도 PC·콘솔 수준의 고해상도 그래픽과 실시간 광원 효과를 구현할 수 있는 GPU 구조를 공개했다. 이번 기술은 AI 연산 전용 가속기를 GPU 내부에 탑재해, 복잡한 이미지 처리와 계산을 하드웨어 단계에서 수행하도록 지원한다.

Arm의 ‘Neural Graphics SDK’는 화면을 더 선명하게 하고 잡음을 줄이는 등 AI 기반 그래픽 기능을 제공한다. 특히 ‘Neural Super Sampling(NSS)’ 기술은 낮은 해상도의 이미지를 고해상도로 변환하면서 GPU 사용량과 전력 소모를 효율적으로 관리한다. 덕분에 모바일 기기에서도 발열과 배터리 부담을 줄이면서 고품질 콘텐츠를 즐길 수 있다.

SDK는 이미 개발자에게 공개돼 차세대 모바일 콘텐츠 환경을 미리 실험할 수 있다. Arm은 GPU가 2026년 상용화될 것으로 예상하며, "모바일에서도 그래픽 성능 기준이 높아지고 있으며, 개발자는 콘솔용 기술을 스마트폰에서도 활용할 수 있다"고 말했다.

실시간 음성 AI로 캐릭터와 상호작용 강화

엔씨소프트는 사용자의 목소리를 다양한 스타일로 변환하는 기술을 선보였다. 포효, 웃음, 숨소리 등 캐릭터 사운드를 실시간으로 합성하며, 발화자의 감정을 반영한 자연스러운 음성을 구현한다.

이 기술은 방대한 오디오 데이터와 게임 사운드 자료를 학습해 개발됐다. AI는 상황과 감정을 반영해 목소리를 생성하며, 캐릭터와 사용자의 상호작용을 자연스럽게 만든다. 기술은 세계 최대 음성 AI 학회 ‘인터스피치 2025’에서 논문으로 채택됐다.

엔씨소프트는 4년 연속 인터스피치에서 연구 성과를 발표했다. 발표된 연구 주제는 호출어 인식, 멀티모달 감정 인식, 브라우저 기반 호출어 인식 등으로 다양하게 진행됐다. 최근에는 ‘청각 지능’ 연구로 확장되어, 사용자의 발화 맥락과 의도를 파악하고 반응하는 AI 기술과 관련된다.

화면과 소리를 동시에 발전시키는 AI

Arm GPU와 엔씨소프트 음성 AI는 다른 영역에서 출발했지만, 몰입 경험 강화라는 목표에서 공통점을 가진다. 화면과 소리가 함께 진화하며 단순한 시청과 청취 경험을 넘어 체감형 콘텐츠 경험으로 이어진다.

기술 발전은 제작 환경에도 변화를 준다. 그래픽 처리, 음성 합성, 사운드 구현 등 핵심 요소가 AI 기반으로 전환되며, 개발자가 다룰 수 있는 표현 범위가 넓어진다. 향후 사용자가 화면과 소리를 체험하는 거의 모든 과정에 AI가 자연스럽게 개입하는 구조가 일반화될 전망이다.

업계는 화면과 소리를 함께 활용하는 AI 기술을 바탕으로 차세대 몰입형 콘텐츠 설계를 고려하고 있다. Arm은 모바일 하드웨어 시장에서, 엔씨소프트는 콘텐츠 제작 환경에서 입지를 강화하고 있다. 두 기술이 실제 제품과 서비스에 적용될 경우, 사용자 체감 몰입도는 이전과 비교할 수 없을 정도로 높아질 것으로 예상된다.