6세대의 4배 성능 ASIC ‘아이언우드’, “엔비디아의 강력 경쟁자”

‘Superpod’ ‘팟’ 칩 9,216개 42.5엑사플롭스 ‘NVLink보다 빨라’

“지연 시간, 처리량, 효율성, 쿼리당 비용 등에서도 우수” 주장

구글 클라우드에서만 독점 제공 “구글 생태계 종속” 도모

[애플경제 전윤미 기자] 구글의 최신 7세대 아이언우드(Ironwood) TPU(TPU v7, 데이터 분석 및 딥러닝용 ‘아식’(ASIC))가 지난 주 그 모습을 드러내면서 글로벌 AI반도체와 칩 시장이 술렁이고 있다. 특히 AI칩 분야에서 선두를 달리고 있는 엔비디아는 내색은 않지만, 내심 긴장할 수 밖에 없다. 심지어 반도체 업계 일각에선 “엔비디아의 진정한 AI칩 경쟁 상대는 AMD나 Intel이 아니다. 정말로 치열하게 경쟁해야 하는 대상은 바로 구글 TPU”라는 평판까지 나오고 있다.

업계에 의하면 엔비디아 CEO인 젠슨 황도 이미 이 사실을 인지하며 심각하게 받아들이고 있는 것으로 전해졌다.

몇 주 안에 다양한 워크로드에 적용

구글 아이언우드 TPU는 앞으로 몇 주 안에 다양한 워크로드에 적용 가능할 것으로 예상된다. 이 소식을 일제히 전한 외신들에 의하면 구글은 이 칩을 ‘추론 중심’ 제품으로 분류하며, “범용 컴퓨팅 전반에 걸쳐 추론 성능의 새로운 시대를 열 것”이라고 주장했다. ‘아이언우드’ TPU는 일단 모델 학습에서 추론으로 전환시킬 수 있도록 설계되었다. 구글이 “‘추론 시대’에 탁월한 성능을 발휘하도록 온보드 사양이 설계된 것”이라고 자신감을 내비치는 이유이기도 하다.

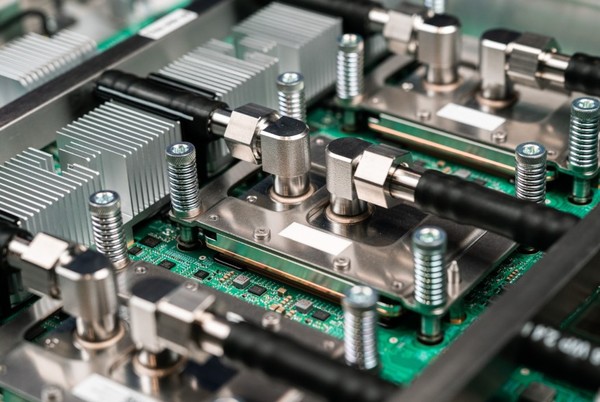

‘아이언우드’ 칩은 192GB의 7.4TB/s HBM 메모리와, 칩당 최대 4,614 TFLOPS의 플롭(FLOP) 성능에 달할 것으로 보인다. 구글이 현재까지 제작한 가장 강력하고 에너지 효율적인 맞춤형 실리콘이다. 6세대 TPU(v6e, Trillium)에 비해 학습 및 추론 워크로드 모두 칩당 4배나 성능이 높다. 5세대에 비해선 무려 10배, 4세대에 비해선 거의 16배나 강화된 성능이다.

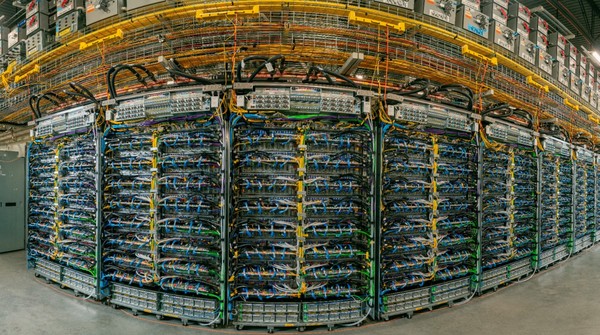

더 중요한 것은 TPU ‘Superpod’를 통해 Pod당 9,216개의 칩을 탑재한 점이다. 이를 통해 총 FP8 컴퓨팅 워크로드에서 누적 42.5엑사플롭스의 성능을 제공한다. ‘SuperPod’의 칩 개수는 매우 효과적인 상호 연결 솔루션을 탑재하고 있음을 보여준다. 이는 실제로 확장성 측면에서 이미 엔비디아의 ‘NVLink’를 능가한다는 평가가 적지 않다.

“NVLink보다 ‘확장성과 상호 연결 밀도’ 높아” 평가

상호 연결의 경우 ‘아이언우드’는 확장형 네트워크인 인텔 칩 인터커넥트(ICI)를 사용한다. 이를 통해 1.8페타바이트 네트워크로 연결된 43개 블록(각 블록은 64개의 칩으로 구성됨)의 ‘Superpod’를 다시 완벽하게 연결할 수 있게 된다.

내부 통신은 다양한 NIC를 사용해 처리된다. 또 TPU에 3D 토러스(Torus) 레이아웃을 사용해 다수의 칩에 걸쳐 고밀도 상호 연결을 구현한다. 엔비디아의 NVLink보다 “확장성과 상호 연결 밀도가 높다”는 평가가 나온다. 구글로선 이런 이유로 ‘SuperPod’가 혁신적인 ‘수퍼’ 솔루션으로 자부하고 있다.

본래 구글은 오래 전부터 AI 하드웨어나 칩 경쟁의 선두를 달렸던 기업이다. AMD, 엔비디아, 인텔보다 훨씬 앞선 2016년에 최초의 TPU 맞춤형 AI 칩을 출시했다. 지난 주 선보인 ‘아이언우드’는 그런 저력을 바탕으로 ‘엔비디아 vs 구글’이라는 가장 치열한 AI 경쟁 구도를 확고히 한 것으로 평가된다.

이번 ‘아이언우드’는 오랜 전부터 키워오던 구글 ‘ASIC에 대한 야망’과도 연결된다. 그렇다면 이게 정말 엔비디아의 AI 지배력에 ‘치명적’일까? 이에 대해 확언은 못하지만, 추론 시대에 ‘아이언우드 TPU’가 중요한 역할을 할 것이란 점은 분명해보인다.

AI가 발달할수록 ‘사고하는 능력’이 차세대 핵심 기술로 부상하고 있다. 당연히 이를 위한 모델 학습이 AI 업계의 주요 트렌드가 되었다. 그런 가운데 엔비디아의 컴퓨팅 포트폴리오가 그런 ‘사고 능력’을 위한 학습 환경에 적합한 고도의 성능을 제공하면서 모든 빅테크들의 필수적 선택지가 된 것이다. 그러나 문제는 “주류 모델이 이미 구축되어 있기때문에 추론 ‘쿼리’ 수가 학습 작업 수를 크게 초과할 수 있다”는 것이다.

그렇다면 이제 추론을 위해선 단순히 최대 ‘TFLOPS’를 얻는 것만이 중요한 것이 아니게 된다. ‘TFLOPS’는 1초당 1조 개의 부동소수점 연산을 수행할 수 있는 컴퓨팅 성능으로 GPU 성능을 나타내는 지표가 된다. 그러나 이젠 최대 속도 못지않게 지연 시간 최소화, 처리량, 효율성, 쿼리당 비용과 같은 다른 변수가 중요해진다.

그런 측면에서 일부 전문가들 간엔 “구글 아이언우드 기능을 보면, 구글이 AI 경쟁에서 엔비디아를 지르고 있다는 생각이 더욱 분명해진다”는 시각도 있다.

우선 아이언우드는 엔비디아 블랙웰 B200 AI GPU에 해당하는 대용량의 온패키지 메모리를 내장하고 있다. 그러나 ‘SuperPod’ 클러스터가 단일 환경에서 9,216개의 칩을 탑재한 만큼, 사용 가능한 메모리 용량은 더욱 크다.

‘추론’ 워크로드 전반에 걸쳐 경쟁력 우수

고도의 추론을 위해선 더 높은 메모리 용량이 필요하다. 칩 간 통신의 오버헤드를 줄이고 대형 모델의 지연 시간을 개선하기 때문이다. 아이언우드는 이 점에서 한층 뛰어나다는 평가다. 이처럼 아이언우드 아키텍처는 명확하게 추론을 위해 설계되었다는게 구글의 설명이다. 즉, “낮은 지연 시간과 높은 전력 효율성을 보장”하는 데 특히 집중했다는 얘기다.

아이언우드는 또한 전력 절감 효과도 큰 것으로 전해진다. 대용량의 추론을 위해 24시간 연중무휴 운영되는 환경 내에서 추론 쿼리를 처리하려면 수천 개의 칩이 필요하다. 그러나 클라우드 공급업체들의 경우 추론이 성능보다 배포와 운영비에 더 집중하는 경향이 있다.

이 점에서 아이언우드는 이전 세대보다 2배 높은 전력 효율성을 보이고 있다. “추론 워크로드 전반에 걸쳐 구글의 TPU를 배포하는 것이 현명한 선택”이란 얘기다.

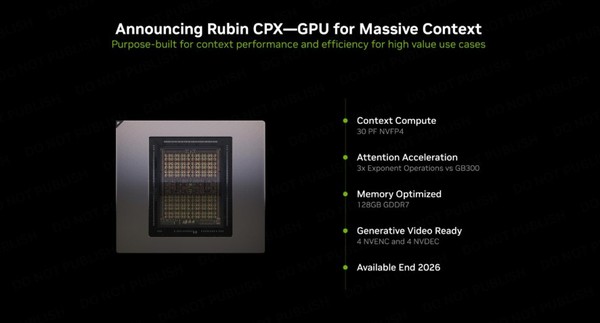

엔비디아도 ‘루빈 CPX’ 랙 스케일 솔루션으로 대항

이제 AI 경쟁은 “누가 더 낮은 지연 시간과, 더 적은 비용, 더 적은 전력으로 더 많은 쿼리를 처리할 수 있는가”로 바뀌고 있다. 이는 엔비디아에게 새로운 경쟁의 무기가 되었고, 구글 역시 이를 포착하고 있다.

더욱 중요한 점은 아이언우드가 구글 클라우드에서만 독점적으로 제공된다는 사실이다. 일를 통해 구글 생태계 종속을 도모하려는 의도다. 그렇게되면 엔비디아 등의 오랜 AI 지배력에 치명타를 입힐 수도 있다. 덕분에 구글 TPU가 엔비디아 칩과 막상막하로 경쟁할 수 있다는 것 또한 분명해진다. 그야말로 엔비디아 진영에 ‘경고’를 발한 셈이다.

물론 엔비디아가 가만히 있진 않는다. 이미 엔비디아는 ‘루빈 CPX’를 통해 루빈의 랙 스케일 솔루션을 (비교적 저렴한) ‘합리적인 가격’으로 출시할 계획이다. 하지만 시간이 지날수록 인텔이나 AMD와는 달리, 구글은 엔비디아의 ‘진정한 경쟁자’로 자리매김할 것이란 전망이 설득력을 얻고 있다.