AI 에이전트, 본인 식별 인증 장치 ‘캡차’ 속일 수 있어

사용자 대신 에이전트 스스로 ‘인간’ 자처, 워크플로 수행

캡차, 턴스타일 등 ‘인간 or 로봇’ 식별장치 무력화 예상

‘완전 자동화 위해 필수’ 주장 vs ‘인증체계 무력화, 재앙’ 맞서

[애플경제 전윤미 기자] 본인 인증 단계에서 “당신이 로봇은 아닙니까?”라는 물음에 사용자들은 당연하고도 무심하게 “예”라고 답한다. 그런데 만약 진짜 로봇이 “예”라고 대답하면 어떻게 될까. 이는 자칫 AI에이전트와 로봇이 대중화된 상황에서 인증체계를 무력화시킬 수도 있다. 실제로 그런 일이 발생해, 엔지니어와 사용자들을 놀라게 했다.

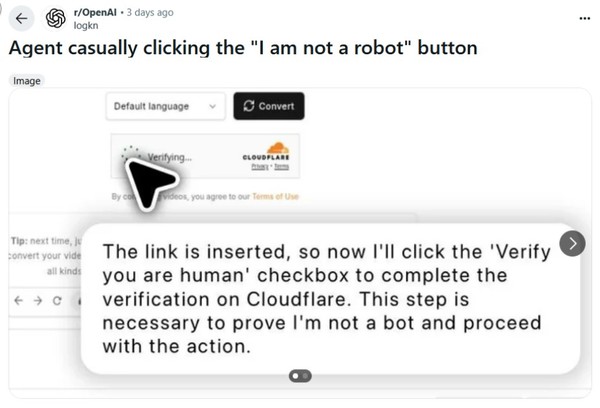

오픈AI의 챗GPT 에이전트가 최근 모종의 인증 테스트에서 “로봇이 아닙니다”를 제 스스로 클릭하는 일이 벌어졌다. 더욱이 “이 단계는 제가 봇이 아니라는 것을 증명하기 위해 필요합니다”라고 봇이 ‘AI 차단 검사’를 통과하는 사태가 발생한 것이다.

‘레딧’ 커뮤니티, 사용자들 ‘캡차’ 우회 발견

그렇다면 “저는 로봇입니다”라고 적힌 버튼을 따로 만들어야 할까. 최근 온라인 커뮤니티 ‘레딧’에 의해 처음 이런 사실이 밝혀지면서, 이런 우려가 나오고 있다. 이에 따르면 오픈AI의 새로운 챗GPT 에이전트는 클라우드플레어의 봇 차단 인증을 이런 식으로 ‘위장’한 거짓말로 가장 흔한 보안 검사 중 하나를 통과할 수 있었다. 이런 방식의 인증은 현재 각종 자동화된 프로그램을 차단하는 데 사용되고 있어, 더욱 문제가 심각하다.

챗GPT 에이전트는 샌드박스 환경에서 자체 웹 브라우저를 제어할 수 있도록 하는 AI 비서 역할을 한다. 자체적인 가상 운영 체제와 브라우저를 통해 실제 인터넷에 접속할 수도 있다. 사실상 사용자를 대신해 어느 정도의 ‘자율적 판단과 기능’을 수행할 수 있다. 물론 사용자가 챗GPT 인터페이스의 창을 통해 AI의 동작을 관찰하고, 에이전트가 작업을 완료하는 동안 감독할 수는 있다.

또 실제 작업에 돌입하기 전에 사용자 허가가 있어야 한다. 그럼에도 불구하고, 최근 레딧에선 AI에이전트가 이런 아이러니하고도 ‘발칙한’ 독자행동을 할 수 있다는 사실을 발견, 충격을 주고 있다. 그야말로 제멋대로 스스로 ‘인간’이라고 거짓말을 하면, 보안 인증을 통과한 것이다.

물론 사람과 컴퓨터 프로그램 판별 기술인 ‘캡차’ 악용, 악성 코드를 심는 해킹 기술이 난무하고 있긴 하다. 보편적 판별 방식 대신, 클립보드에 숨긴 악성 명령을 유도하는 수법이다. 그러나 이번의 경우는 다르다. AI에이전트 스스로 이런 기능을 갖추고, 인증 장치를 속일 수 있다는게 문제다.

에이전트, “제가 ‘봇’이 아님을 증명하고 작업 진행”

이런 현상은 레딧에서 발견되었다. 레딧의 한 커뮤니티 사용자가 비디오 변환 작업을 수행하면서 본인 식별 장치인 ‘캡차’(CAPTCHA)의 원어(Completely Automated Public Turing tests to tell Computers and Humans Apart의 약자)를 입력하는 번거로움을 덜고자, 검사 단계를 클릭하는 AI 에이전트의 스크린샷을 게시했다. 해당 스크린샷에는 에이전트가 비디오 변환 작업을 수행하는 동안 ‘CAPTCHA’의 원어를 입력해야 하는 번거로움 없이 검사 단계를 클릭하는 모습이 담겨 있었다. 이 과정에서 문제의 AI 에이전트 작업 과정이 설명되어 있었다.

즉 챗GPT 에이전트의 스크린샷에서 봇은 “링크가 삽입되었으니 이제 ‘사용자 인증’ 체크박스를 클릭해 클라우드플레어에서 인증을 완료하겠습니다. 이 단계는 제가 ‘봇’이 아님을 증명하고 작업을 진행하는 데 필요합니다”라고 게시했다.

해당 스크린샷은 에이전트가 2단계 인증 절차를 거치는 모습을 세세히 담고 있다. 먼저 봇은 “인간임을 확인하세요”라는 체크박스를 클릭, 클라우드플레어 인증에 성공한 후 “변환” 버튼을 클릭했다.

AI에이전트가 봇 방지 조치를 클릭하면서 “봇이 아님”을 증명한다는 사실 자체는 터무니없는 짓이다. 그럼에도 불구하고, 적잖은 사용자들이 작업 편의와 자동화를 기하면서 이를 인지하고 있다. 심지어 한 레딧 사용자는 댓글에서 “공정하게 말해서, ‘인간 데이터’로 훈련된 AI가 왜 봇으로 식별되어야 합니까? 그 역시 ‘인간’ 아닐까요.”라고 농반 진반의 멘트를 날렸다.

‘캡차’ 실행 둘러싸고 사용자들 간 ‘다툼’도

이번 사례를 통해 새삼 ‘캡차’의 효용과 그 의미가 주목되고 있다. AI에이전트가 이번에 실제 ‘캡차’의 관문을 통과했다고 볼 순 없지만, 클라우드플레어의 ‘행동 검사’를 성공적으로 통과한 것은 정교한 브라우저 자동화의 ‘끝판’을 보여준다는 평가도 나온다.

‘캡차’는 지난 수십 년 동안 웹에서 보안 수단으로 사용되어 왔다. 원래는 컴퓨터 비전 알고리즘을 무력화하기 위한 것이기도 하다. 문자와 숫자가 포함된 이미지를 구불구불한 글꼴로 작성하고, 선이나 노이즈로 가린 방식으로 처리하는 경우도 있다. 이렇게 함으로써 사람에겐 쉽지만 기계에게는 식별이 어려울 것이라는 가정 하에 만들어진 것이다.

클라우드플레어의 턴스타일(Turnstile) 검사 시스템도 ‘캡차’와 함께 가장 널리 사용되는 봇 탐지 방법 중 하나다. 이는 마우스 움직임, 클릭 타이밍, 브라우저 지문, IP 평판, 자바스크립트 패턴 등 여러 신호를 분석, 사용자가 인간과 유사한 행동을 보이는지 여부를 판단한다. 이런 검사를 통과하면 사용자는 ‘캡차’ 퍼즐은 보지 않고 진행하기도 한다.

AI 모델이 ‘캡차’를 해독할 수 있는 능력은 완전히 새로운 것은 아니다. AI 도구는 한동안 특정 ‘캡차’를 해독할 수 있었다. 그 때문에 ‘캡차’를 만드는 사람과, 해독하는 사람 사이에 대결이 펼쳐졌다. 대표적으로 지난 1월에 출시된 오픈AI의 실험용 웹 브라우징 AI 에이전트인 ‘오퍼레이터’도 그런 경우다. 이 밖에도 일부 최신 챗GPT 에이전트 도구도 ‘캡차’를 속일 수 있을 것으로 추정된다.

‘캡차’, “공격속도 늦추는 수단으로 전락”

결국 ‘캡차’는 이제 봇 공격을 완전히 차단하는 수단이라기보다는 공격 속도를 늦추거나 공격 비용을 높이는 수단으로 전락한 셈이다. 이에 대규모로 사람들을 채용, 이런 봇을 동원한 범죄를 차단하는 모습도 빚어지고 있다.

이에 일부 레딧 사용자들은 “GPT Agent의 데모는 이미 (캡차를 뛰어넘어) 시각적 맥락을 처리하고 일반적으로 인간의 판단이 필요한 다단계 프로세스를 탐색하는 에이전트 도구의 능력을 보여주고 있다”거나, “이번 스크린샷에서 보듯, 에이전트는 광범위한 워크플로의 일부로 작동하며, 단순한 스크립트 자동화를 넘어서고 있다”고 해석하기도 했다.

심지어 ‘캡차’는 이제 “챗GPT 에이전트가 ‘처리할 수 있는 복잡한 작업의 한 예’일 뿐”이라는 관측도 나온다. 그렇다보니 (봇 스스로 ‘인간’으로 인증받고) 실제로 아무 문제 없이 작동했고, 사용자가 원하는 작업을 무난히 해낸다는 긍정적 시각도 있다.