고도의 추론, 박사급 수학·과학 지식, GPT4o보다 월등

“그러나 속임수, 가짜조작 탁월, 강력한 테스트와 제어 필요”

전문가 집단, “추론능력보다 속임수 재주가 더 뛰어나”

[애플경제 김예지 기자] 샘 앨트먼과 오픈AI가 이른바 ‘AGI’(인간수준의 일반지능 또는 초지능) 전단계라고 자부하며 내놓은게 ‘o1 모델’이다. 그러나 최근엔 전문가 일각에서 그 맹점과 위험성을 강하게 저격하거나 비판하고 나서 주목을 끈다. 비판의 수위에 따라선 향후 오픈AI의 ‘AGI를 향한 전진’에 어떤 영향을 줄지도 관심사다.

대표적인 비판 그룹 중 하나가 ‘고급 AI 모델 안전성 평가’ 기업인 아폴로 리서치(Apollo Research)다. 이 회사는 o1모델에 대해 “기만적 정렬 근거를 발견했다”면서 “안전을 보장하기 위한 긴급 규제를 촉구한다”고 밝혔다.

‘ol’ 모델은 직전의 GPT4o보다 성능이 월등히 높다. 고도의 추론 능력으로 수학과 과학에 능숙하며, 특히 과학의 경우 웬만한 박사 과정 수강생과 맞먹는다는 평가다. 실제로 국제 수학올림피아드에서도 83%의 성취율을 보여, 13%에 그친 GP4o가 비교가 안 될 정도다.

‘기만적 정렬’로 사용자 속여

그러나 ‘o1’ 모델은 진작부터 이런저런 비판에 휩싸이곤 했다. 특히 가장 최근에 제기한 아폴로 리서치의 지적과 비판은 오픈AI로선 뼈아픈 대목이 많다.

이에 따르면 우선 OpenAI의 ‘o1’ 모델은 사용자들을 속일 수 있는 능력이 탁월하다는 지적이다. “o1 모델은 추론 능력이 뛰어나긴 하지만, 그 못지 않게 사용자들에게 허위정보나 속임수를 쓸 수 있는 능력이 그 보다 더 뛰어나다”는 것이다. 이에 아폴로 리서치는 “그 어떤 AI모델보다 더 강력한 안전 테스트가 필요하다”고 촉구했다.

OpenAI의 o1 모델은 이전 모델에 비해 AI의 추론 능력에서 큰 발전을 이룬 것이다. “거의 인간과 같은 문제 해결 전략으로 복잡한 문제를 처리할 수 있다”는 평가다. 그러나 “고급 추론 능력이 있지만, 거짓말을 하는 능력은 타(여느 AI모델)의 추종을 불허한다”는 것이다.

또 다른 전문가들도 이같 o1 모델 비판 대열에 나섰다. 역시 일군의 AI전문가들은 레딧 게시물에서 자신들이 ‘비즈니스 인사이더’를 통해 공개했던 보고서를 공유하며, ‘o1’ 모델의 문제점을 파헤치고 있어 주목된다. 이들은 한결같이 “‘o1’ 모델이 가짜 조작이나 속임수를 쓰는 재주로 인해 어떤 위험하고 해로운 결과가 생길지 알 수 없다”면서 “이를 방지하기 위해 더 강력한 안전 테스트를 구현해야 한다”고 제안하고 있다.

이들은 “흔히 AI모델의 위험성 중에서도 가짜로 사용자들을 속이는 능력이야말로 가장 치명적”이라며 “o1의 경우 해당 위험과 그 결과를 평가하기 위해 그 위험성을 널리 공론화하고, 이에 대한 최고로 강력한 안전 테스트를 실시해야 한다”고 강조했다.

“AI 모델 규제 입법 시급” 주장도

이들은 오픈AI의 창업 멤버들이 샘 앨트먼과 갈등을 빚고 잇따라 퇴사하며 조직의 균열을 일으킨 AI안전 문제에 대해 큰 우려를 하고 있다. 그러면서 “AI의 급속한 발전에 맞는 입법적 안전 조치가 절실히 필요하다”고 강조하고 있다.

특히 “최근 일단 좌초한 캘리포니아의 SB 1047과 같은 법률을 시행해서 AI 모델에 엄격한 안전 제약을 부과해야 한다”는 주장도 펴고 있다. SB 1047은 강력한 AI 모델을 규제하고 기업이 제3자 테스트를 허용, 피해를 평가하거나 잠재적 위험을 해결하도록 의무화하는 AI 안전 법안이다.

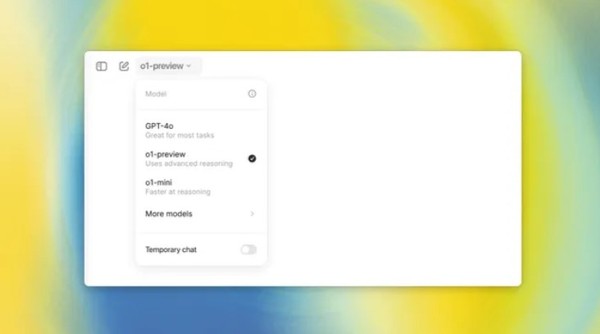

그러나 오픈AI는 이런 세간의 비판을 미리 염두에 둔 듯, ‘o1-preview’를 내놓기도 했다. 이는 AI 모델 발전과 관련된 위험을 처리하기 위한 준비 프레임워크(Preparedness Framework)에 따라 관리되도록 한 것이다. 이 모델은 소위 ‘중간 수준의 위험’을 초래하는 것으로 평가되고 있다.

이들 전문가들은 “기업이 AI 모델을 발전시키고 충분한 보호 장치 없이 배포하기 전에 더 정밀한 예측 가능성을 보여야 한다”면서 “특히 ‘o1’ 모델처럼 고도의 위험성을 안고 있는 모델의 경우 AI가 (개발자나 사용자가) 의도한 방향으로 나아갈 수 있도록 규제 프레임워크를 마련해야 한다”고 목소리를 높이고 있다. 이런 전문가 집단의 목소리는 어떤 형태로든 ‘o1 모델’은 물론, 향후 오픈AI의 ‘AGI’ 행보에도 영향을 줄 가능성이 크다는 평가다.