디퓨전 기술 가운데 ‘글리젠’ 주목, ‘멀티 컨디션’ 입력 가능

바운딩 박스, 텍스트 동시 입력, “농장주 의도한 이미지 생성”

비전AI는 학습 훈련 데이터 부족 등으로 실용화엔 한계

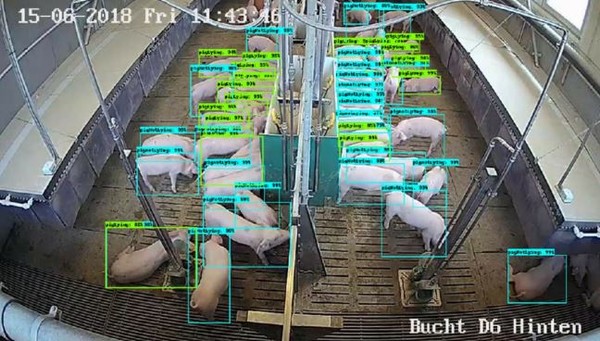

독일의 스마트축산 개념도. (출처=인트플로우, 정보통신기획평가원)

[애플경제 김예지 기자] 스마트 농업에 비해 스마트 축산은 좀더 어렵다는게 현장 전문가들의 견해다. 무엇보다 지속적으로 관찰, 분석된 학습데이터의 양이 절대 부족하다는게 그 원인이다. 이에 최근엔 비전AI 방식 또는 이미지 생성(text-to-image)기술 등이 현장에 적용된 경우도 있어 눈길을 끈다.

그 중에서도 특히 후자, 즉 텍스트 입력을 기반으로 이미지를 생성하는 스테이블 디퓨전(Stable Diffusion) 방식이 학습 훈련이나 기술면에서도 좀더 향상된 방법이란 평가다. 이는 실제 존재하지 않는 상상속의 이미지를 생성하는것이 가능하다는 점이 무기다.

‘글리젠’, 동일한 캡션 다수 입력으로 ‘주목’

그러나 디퓨전 방식은 생성 결과의 무작위성으로 인해 동일한 캡션(컨디션)의 입력에 대해 일관되지 않은 이미지가 생성되는 한계가 있다는 지적이다. 여러 컨디션을 동시에 입력으로 받을 수 없다. 또한 글라이드(GLIDE), 이메진(Imagen), 달리2(DALLE2) 등은 텍스트만을 입력 컨디션으로 받을 수 있다. 스테이블 디퓨전은 다양한 형태의 컨디션을 받을 수는 있지만, 그 중 하나의 컨디션만 골라야 한다. 즉, 바운딩 박스(Bounding Box)와 이를 설명하는 텍스트가 동시에 입력될 수는 없다는게 한계다.

또한 디퓨전 모델을 학습하기 위해선 엄청나게 많은 컴퓨팅 소스가 필요하다. 이는 자칫 수많은 GPU를 필요로 할 수 있어, 이는 실용화의 가장 큰 장애물로 꼽힌다.

이를 해결하기 위해 떠오른 모델이 ‘GLIGEN이다. 이는 멀티 컨디션을 입력받을 수 있다. 또 바운딩 박스와 이를 설명하는 텍스트를 동시에 입력으로 받을 수 있다. 즉, 캡션을 유지하면서 그라운딩(grounding) 조건(그림 속 물체나 이미지 등)이나, 레퍼런스 이미지, 키포인트에 대한 바운딩 박스 등 추가적인 입력을 활용, 의도한 이미지를 생성할 수 있는 것이다.

사전 학습된 모델의 방대한 개념 지식을 유지하면서도 새로운 그라운딩 정보를 주입하는 것이 글리젠 구조의 특징이다. 이를 위해 원래 모델의 가중치를 동결하고, 새로운 그라운딩 입력을 받아들이는 새로운 학습 가능한 ‘gated transformer layer’를 추가할 수도 있다.

이러한 구조는 학습 도중에도 사전 학습된 모델에 새로운 정보를 점진적으로 융합하는 가운데, 샘플링 과정에서 높은 품질과 제어 가능성을 보장받을 수 있게 된다.

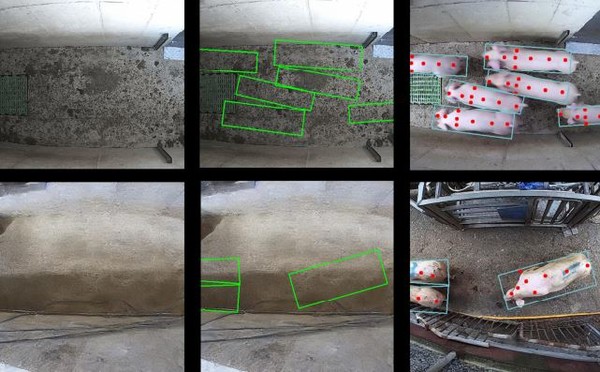

스마트축산을 위한 전이학습 개념도.(출처=인트플로우, 정보통신기획평가원)

그라운딩, 데이터 토큰 추출, 글리젠 전이학습

최근엔 이러한 GLIGEN 모델을 기반으로, 양돈의 자세, 품종, 크기 등의 정보가 포함된 약 수만 쌍의 데이터를 활용, 모델을 전이학습시킨 사례도 소개되고 있다. 전광명 인트플로우 대표이사는 “이 과정에서 H100 GPU가 탑재된 서버를 사용하여 10만 회의 Epoch 동안 학습을 진행하였으며, 결과적으로 실제 양돈장의 촬영 사진과 구분하기 어려운 수준의 고품질 이미지를 생성할 수 있었다”고 최근 정보통신기획평가원을 통해 공개한 연구 보고서에서 밝혔다.

그 과정에서 그라운딩 데이터와 캡션 데이터 각각에 대한 토큰(token)을 추출, 글리젠( GLIGEN)의 전이학습에 활용한 것으로 전해졌다. “이는 주어진 어노테이션에 따라 동물의 마릿수, 위치, 크기 등을 정확하게 반영하는 이미지를 생성할 수 있음을 의미한다”는 것이다. 전 대표는 “또한, 이를 통해 축산동물 데이터의 부족을 극복하고, AI 모델의 취약한 부분을 보완하여 학습시킬 수 있는 가능성을 열어준다”면서 “양돈 이미지에 대해 전이학습한 그릴젠을 이용해 주어진 어노테이션과 배경 이미지로부터 가상의 돼지를 생성한 결과를 나타낸다.”고 소개했다.

이를 통해 이미지는 실제 촬영된 이미지와 조금도 다를 바 없이 원하는 위치와 방향에 돼지를 생성하여 그려준다. 더욱이 주어진 어노테이션에 대응하는 이미지가 생성되어 이 자체로도 비전AI 검출 모델의 학습 데이터로 기능할 수 있는 한 쌍의 데이터셋이 생성되었다“고 한다.

비전AI, 스마트축산에 적격 “그러나 제한적 실험 환경”

한편 ‘비전AI’ 기술도 스마트축산의 중요 기술이긴 하다. 이는 화면 내 동물(소, 돼지, 닭 등)의 영역을 검출하고, 이들의 움직임을 추적하여 각 동물의 행동을 식별하는 것이다. 이러한 기능은 기본적으로 인간이 수행할 수 있는 업무이긴 하다. 그러나 인간이 쉬지 않고 끊임없이 동물 한 마리 한 마리의 정보를 정밀하게 기록하는 것은 능력의 한계가 작용할 수 밖에 없다. “이때 비전AI는 적절한 카메라 설비가 갖추어져 있다면, 농장 내 수백에서 수만 마리의 동물 개체별 상태를 정확하게 파악하고 기록하며, 필요한 경우 작업자에게 알릴 수 있는 능력을 제공한다.”고 했다.

그러나 다양한 축산동물을 분석하는 과정에서 비전AI 모델은 제한적 실험 환경에서는 잘

동작하지만 실제 농장 환경에서는 성능이 크게 저하되는 경우가 많다는 지적이다. 실제로 “환경 속에서 비전AI 모델이 효과적으로 동작하지 못하는 주된 원인은 학습 데이터의 부족에 있다”는 지적이다. 특히, 모델이 학습 과정 중 처음 접하는 상황에 직면했을 때, 오류 발생률이 높아지는 것은 지도학습 기반 AI 모델의 근본적인 한계로 인식되고 있다

이에 비전AI보다 한 단계 높은 ‘글리젠’ 기술 등의 첨단 디퓨전 기술이 미래의 스마트 축산을 위한 유용한 방안으로 떠으로고 있다.