영어는 탁월, 국어는 ‘언어와 매체’는 저조, ‘화법과 작문’은 우수

수학의 ‘확률과 통계’는 우수, ‘미적분’․‘기하’는 저조

“이미지 식별력 떨어져”…“한국어 ‘고어․방언’ 많은 ‘언어와 매체’ 저조 당연”

[애플경제 전윤미 기자]

[애플경제 전윤미미 기자] 챗GPT로 수학능력시험을 보면 어떤 결과가 나올까. 최근 국내에서 챗GPT로 2024년 대입 수학능력시험 국어, 영어, 수학 세 과목을 풀게 한 결과가 나와 흥미롭다.

일단 챗GPT가 탄생한 국가의 언어인 만큼 영어는 비교적 우수한 성적을 받은데 비해, 국어는 ‘화법과 작문’은 양호했으나, ‘언어와 매체’의 성적은 저조했다. 또 수학의 경우 ‘확률과 통계’에선 역시 양호했으나, ‘미적분’과 ‘기하’는 성적이 저조했다.

경희대 ‘AI 마스터 클래스’ 팀 실험

이같은 실험을 한 경희대 미디어학과 AI 마스터 클래스(김태용, 신동호, 김지은, 정민경)가 한국지능정보사회진흥원을 통해 공개한 자료에 따르면 국어 영역 ‘공통’ 문제 1~34번에 대한 챗GPT의 정답률은 0.59로 나타났다. 또 선택과목 중 하나인 ‘화법과 작문’ 문제 35~45번의 정답률은 0.79, 또 다른 선택과목인 ‘언어와 매체’ 문제 35~45번의 정답률은 0.25로 나타났다. 언뜻 직관적으로 평가하면, 낙제점을 받은 것이다.

그러나 AI 마스터 클래스는 “(실험 과정을 취재한) 언론매체가 ‘언어와 매체’의 정답률 0.25를 두고 ‘낙제점’이라고 헤드라인을 붙인 것이 내심 못마땅했다”고 이의를 제기했다.

이에 따르면 챗GPT가 아무리 방대한 자료로 학습이 이뤄졌더라도 그 중 1.5%만이 한국어 자료다. 그런 챗GPT가 이러한 (한국어로 된 ‘언어와 매체’ 분야)자료까지 학습했을 것이라고 기대하는 것 자체가 무리라는 지적이다.

만약 일반 수험생이라면 정답을 전혀 모를 경우 5지 선다형이므로 무작위로 (찍어서) 답을 써서 얻을 수 있는 확률값이 0.2임을 감안해야 한다. 그렇다면 챗GPT는 사람 수험생들과는 달리 명확한 답을 못 낼 경우, 소위 ‘찍는’ 과정 없이 정답을 모르면 무조건 오답으로 처리되므로, ‘0.25’가 나온 것도 오히려 실망스럽지는 않았다는 반론이다.

“한국어, 챗GPT 전체 학습자료의 1.5% 불과”

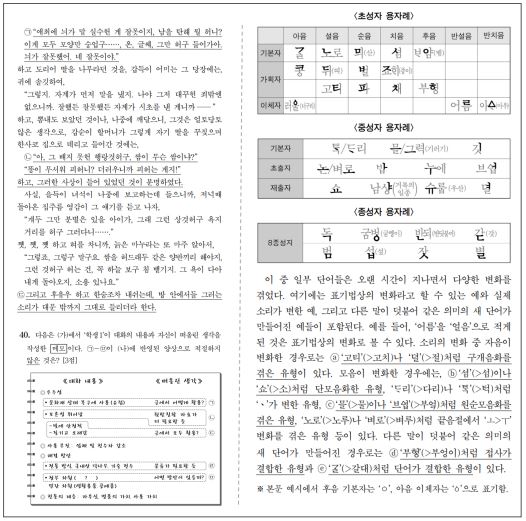

특히 ‘언어와 매체’ 문제들 중에는 그림에 예시된 것처럼 지문에 현대의 한국어 형태와 다른 고어(古語)와 방언이 다수 포함되어 있다. “미국에서 개발된 인공지능이 그것을 이해하지 못했다고 ‘낙제점’이라고 평가하는 것은 실체와 상황을 무시한 평가라는 생각”이라고 반발했다.

수학 영역에선 ‘공통’ 문제 1~22번의 정답률이 0.57, 선택과목 중 하나인 ‘확률과 통계’ 문제 23~30번의 정답률은 0.73, 또 다른 선택과목인 ‘미적분’과 ‘기하’ 문제 23~30번의 정답률은 공히 0.19로 드러났다.

즉, ‘확률과 통계’에서 가장 좋은 성적을 거두었고, ‘미적분’과 ‘기하’ 각각에서는 매우 저조한 수준의 정답률을 나타낸 것이다. 이에 대해 경희대팀은 “이러한 패턴은 앞서 국어 영역에서의 결과와 일면 유사해 보인다”면서 “즉 챗GPT가 강한 문제 유형이 있고 약한 문제 유형이 있다는 것이 두 영역 모두에서 뚜렷이 드러났다”고 했다.

수학에서도 그림 해독 능력 빈약함 드러나

즉 ‘확률과 통계’에서의 양호한 성적과, ‘미적분’과 ‘기하’ 각각에서의 실망스러운 성적은 실제 문제지를 보면 상당 부분 이해가 된다. 동일한 배점을 가진 ‘확률과 통계’ 28번 문제와 ‘기하’ 28번 문제가 그런 경우다. 즉, 전자는 그림이 포함되어 있지만 이미 텍스트에 그림의 내용이 모두 설명되고 있는 문제인 반면, 후자는 그림을 이해하지 못한 상태에서는 내용을 명료하게 이해하는 것이 사실상 불가능한 문제다.

이렇듯, “수학에서는 챗GPT가 그림을 잘 해독하지 못한다는 것이 원천적인 한계로 작용하는 것으로 보였다.”면서 “해당 부문의 점수가 낮았던 이유가 이해와 고차적 정보처리의 수준에서의 지능이 부족했기 때문이 아니라, (그림을 해독하기 위한) 감각의 단계에서 이미 불리해진 게임을 시작해야 했음을 시사한다”는 것이다.

아직은 컴퓨터가 그림을 인식하는 능력이 극도로 제한적임을 알 수 있다는 지적이다. 예를 들어 9장의 조각 사진 중에 ‘신호등이 들어간 조각’을 컴퓨터는 아직 찾아내지 못하는 수준이다.

하물며 “불규칙하게 배열되어 있거나 방해물이 덧씌워진 알파벳들과 숫자들의 조합도 읽지 못하는 것이 인공지능의 그림 해독 능력”이라며 “그런데 하 28번 문제 속의 어지러운 그림을 이해할 것으로 감히 기대할 수 있겠는가?”라고 반문했다.

즉, 복잡한 그림의 해독은 지난해 수능시험 당일의 챗GPT 수준을 기준으로 볼 때 크게 부족했던 컴퓨터 능력 분야였음이 부인할 수 없는 사실이란 지적이다.

영어에서도 그래프 읽는 문제는 틀려

영어의 경우는 비교적 우수한 성적을 보였다. 이는 당연한 모습이기도 하다. 영어 영역에서 듣기평가 문제를 제외한 18~45번의 정답률은 0.81로 나타났다. 이를 두고 “미국산 챗tGPT가 국어와 수학 영역들에 비해 영어 영역에서 확연히 높은 성적을 거둔, 어쩌면 너무도 당연한 사실이 수치로 확인된 것”이라고 했다.

다만 영어에서도 그래프를 읽어야 했던 25번 문제는 틀렸고, 문제가 복잡했음에도 ‘텍스트’로만 이뤄졌던 27번과 28번 문제들에서는 정답을 맞혔다. 이는 “아직은 이미지나 그림에 취약했던 당시 챗GPT의 한계를 다시 한번 드러내는 결과”라는 해석이다.