최적화된 파운데이션 모델로 ‘범용AI 시스템’ 시대 개막

방대한 데이터 학습한 모델, 사용자 ‘미세조정’후 다양한 활용

[애플경제 전윤미 기자] 최적화된 모델로서 날로 관심을 끌고 있는 것이 파운데이션모델(Foundationmodel)이다. 이는 말 그대로 ‘기초’나 ‘토대’(파운데이션)가 되는 학습 모델이라로 할 수 있다.

일단 방대한 양의 데이터를 자기지도학습(Self-supervised learning)을 통해 학습한 모델로 이해할 수도 있다. 이를 개별 사용자나 기업이 각자의 용도나 작업 특성에 맞게 미세조정(Fine-tuning)을 하는 것이다.

이는 초대형 생성AI시대가 등장하면서 더욱 그 중요성이 커지고 있다. 즉 가급적 많으면 많을수록 좋은 것이 초대형 AI의 특성이다. 그러나 무조건 많은 데이터라기보단, 양질의 데이터가 많을수록 좋다는게 정확한 해석이다. 문제는 그럴만한 자본과 비용, 그리고 기업의 역량이다. 웬만한 단위 기업으로선 그런 방대한 양질의 데이터셋을 갖추기란 불가능에 가깝다.

영세기업 등 ‘파운데이션 모델 활용’

실제로 구글, MS, 아마존 등 글로벌 빅테크가 초대형AI 개발에 앞장서고 있으며, 국내에서도 네이버, 카카오 등 준 재벌급 대기업들이 이에 참여하고 있는 현실도 이를 보여주는 것이다. 중견 혹은 중소기업들로선 감히 꿈꾸기조차 힘든 상황이다.

특히 파운데이션모델을 구축하기 위해서는 막대한 컴퓨팅자원이 소요되는 대규모 학습이 필요다. 이에 구글이나 페이스북, MS, 그리고 중국의 화웨이 등 글로벌 대기업이 주도하고 있다. 최근엔 오픈AI, AI21 랩스 등의 AI 전문 스타트업을 중심으로 시도되는 정도다. 한국지능정보사회진흥원은 “반면에 학계의 참여는 상대적으로 저조한 편”이라며 “국내에서는 한국어 이해능력에 초점을 맞춘 한국어 언어 모델에 관한 연구가 활발히 이루어지고 있다”고 밝혔다.

그렇다보니 이미 방대한 데이터셋을 구축하여 만들어진 범용의 학습모델을 기반으로 이를 다시 각자의 쓰임새에 맞게 데이터 등을 추가 내지 조정(미세조정)하여 활용하는 방식이 효율적이고 경제적이다. 곧 파운데이션 모델이 인기를 끌고 있는 것이다.

이에 정보통신기획평가원도 “개별 기업이나 조직이 방대한 파운데이션모델을 구축하기란 현실적으로 불가능하다”면서 “글로벌 기업 등에 의한 파운데이션 모델의 확산은 앞으로 AI 모델의 성능을 향상시킬 뿐 아니라 범용의 인공지능 시스템의 탄생을 예견하고 있다”고 전망했다.

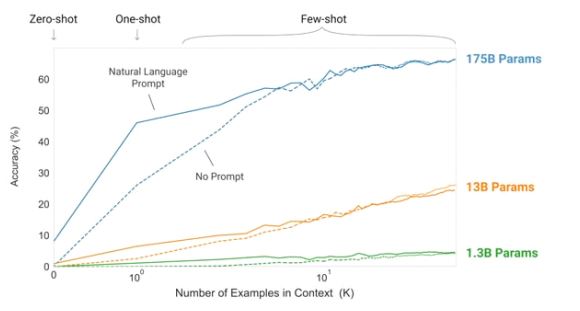

이들 전문가들에 의하면 최신의 대표적인 파운데이션모델로선 GPT-3를 꼽을 수 있다. 이는 아예 미세조정조차 필요없도록 했다. 수행해야 할 작업에 대한 적절한 예시를 주는 정도에 그치는 퓨샷(Few-shot) 러닝과, 약간의 설명만을 추가하는 프롬프트 러닝만으로도 충분하게 한다. 그 정도만으로도 모델이 한번도 학습해본 적없는 작업을 수행해낼 수 있음을 보여주고 있다. “파운데이션모델이 보여주는 보편적인 데이터 이해능력과 대규모 데이터학습 능력을 통해 인공지능 생태계가 어떻게 변화될 것인지를 보여주는 것”이란 해석이다.

‘지식증류’ 등 파운데이션 모델 최적화도

나아가선 이런 파운데이션 모델의 효율성을 높이는 최적화 기법들도 발전을 거듭하며 주목을 받고 있다. 이에 관한 전문 연구 결과를 최근 제시한 한국지능정보사회진흥원에 따르면 전문가에 따라 다소 기준이 다르긴 하지만, 대체로 ‘지식 증류’(Knowledge distillation), ‘프루닝(Pruning), ’모델 구조 변경‘, ’양자화(Quantization)‘ 등이 기법이 제시되고 있다.

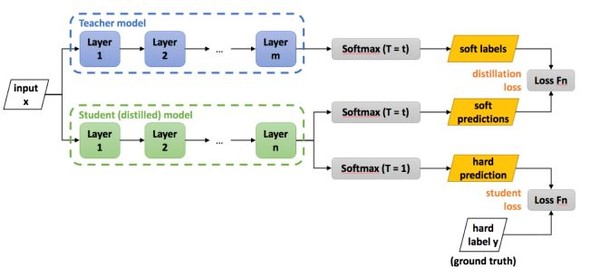

그중 ‘지식증류’는 이미 학습이 완료된 거대한 모델의 지식을 비교적 작은 모델에 증류하는 방식이다. 마치 스승이 제자에게 지식을 전수하는 것과 흡사한 개념이다.

이 방식은 애초 ‘스승’에 해당하는 거대 모델을 모방하는 것이 목적이다. 그렇다보니 한계가 있다. 즉 기존의 거대 모델을 뛰어넘는 성능을 얻는 것이 힘들다는 지적이다. 이에 미세조정 후 배포단계에서 모델의 크기를 줄이고, 추론속도는 향상시키는데 초점을 맞춘 것이 지식증류 방식이라는 평가다.

매개변수 가중치 변경, 파라미터값 정수 매핑으로 최적화

‘프루닝’은 불필요한 매개변수(파라미터)의 가중치를 제거하는 기법이다. 즉 사전학습된 모델이나 미세조정된 모델에서 그다지 중요치앟거나 불필요한 매개변수에게 부여되는 가중치를 아예 ‘0’으로 만들어버린다. 그럼으로써 연산 과정에서 이를 생략하여 전체 사용량을 줄이고, 속도를 빠르게 만드는 기법이다.

이때 중요한 것은 과연 특정 매개변수의 가중치의 중요도를 어떻게 평가할 것이냐 하는 것이다. 이에 컴퓨터 과학자들은 신경망 모델에서 보편적으로 가중치가 ‘0’에 근접할수록 그 영향력이 미미하다는 점에 착안했다.

즉, ‘0’에 가까운 가중치를 찾아서, 아예 이를 ‘0’으로 만들어버린다. 이는 ‘매그니튜드 웨이트프루닝’(Magnitude weightpruning) 기법이으로 불린다. 또 미세조정 과정에서 ‘0’으로부터 멀어지는 가중치를 찾은 다음, 이를 역시 ‘0’으로 만들어버리는 ‘무브먼트 웨이트 프루닝’(Movement weight pruning) 기법 등도 있다.

이처럼 학습이나 모델의 수정을 통해 최적화를 기하는 방법 외에도 GPU 등의 연산속도를 빠르게 최적화하는 기법도 있다. ‘양자화’가 그처럼 연산의 효율을 향상시키는 방법 중 하나로 꼽힌다.

이는 모델의 가중치 파라미터 값을 부동 소수점이 아닌 정수로 매핑하는 방법이다. 예를 들면, 32비트 부동소수점으로 표현된 모델의 가중치값 중, 가장 큰값을 정수 127에, 가장 작은값을 –128에 매핑한다. 그런 다음 나머지값들을 전부 가장 가까운 정수로 변환하여 모든파라미터값을 ‘8bit 정수형’으로 변환하는 것이다.

한국지능정보사회진흥원은 “이때 정수로 변환하는 과정에서 어느 정도의 오차가 발생할 수있어 모델의 정확도가 하락하는 문제가 있으나, 실험을 통해 검증한 결과, 그 격차가 크지않은 경우가 많다”고 설명한다.