MS 애저, 구글 GCP, AWS 등 글로벌 클라우드 ‘앞다퉈 LLM모델 선봬’

가장 공격적인 MS ‘애저 오픈AI’, 구글도 ‘버텍스AI 생성AI 지원’, ‘생성AI 앱 빌더’

[애플경제 전윤미 기자]클라우드를 통해 LLM(대형언어모델)이 제공되는 추세가 확산되고 있다. 뉴욕타임즈(NYT)는 챗GPT가 등장한 직후 “MS는 AI기술을 장악하기 위해 오픈AI에 거대한 투자를 감행하고 있다.”면서 이같은 추세를 앞서 짚은 바가 있다.

주요 외신들도 최근 추세에 일제히 주목

표현은 다르지만 테크크런치, CNBC 등도 이같은 맥락의 추세를 전하고 있다. 이들 매체 종합한 후 나름대로 분석 보고서를 낸 바 있는 한상기 테크프론티어 대표는 “LLM을 서비스에 도입하는 클라우드 인공지능 서비스는 모든 클라우드 서비스에서 제공하는 필수 아이템”이라며 “특히 LLM에 대한 관심이 폭증하면서 주요 클라우드 기업은 빠르게 오픈AI 서비스를 포함해 주요 LLM 모델을 서비스 안에서 제공하는 움직임을 보였다”고 전했다.

가장 공격적인 곳은 오픈AI와 협력한 마이크로소프트(MS)의 애저 클라우드다. 애저에 오픈AI 서비스를 추가하며, 그 기능을 확장해가고 있다. 구글 역시 구글 클라우드를 통해 자체 개발한 생성AI모델 등을 제공하면서, 최근엔 이를 통해 머신러닝 플랫폼 ‘버텍스AI’를 확장하는 움직임을 보이고 있다. 아마존도 기존의 AWS에 생성AI를 접목한 SaaS 사업자들과 협업하면서, 역시 클라우드 기능을 높여가고 있다.

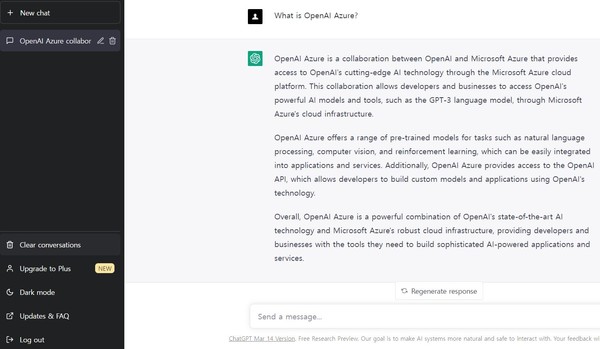

MS 애저, ‘애저 오픈AI’로 대규모 생성 모델 활용

우선 MS 애저는 ‘애저 머신 러닝’과 같은 애저 서비스를 통해서 고객이 모델 학습을 하도록 하고 있다. 즉, 애저 오픈AI 서비스를 통해 대규모 생성 모델의 성능을 활용할 수 있도록 하는 것이다. MS의 자료에 따르면 이에 쓰인 엔비디아의 ‘H100 텐서 코어 GPU’는 최대 256개를 연결할 수 있으며 종전의 A100 GPU에 비해 학습 속도가 9배, 추론 속도는 최대 30배 빠른 것으로 알려져있다.

앞서 마이크로소프트는 ‘대규모 AI’를 애저의 기본적 작동 원리로 추구했다. 이를 위해 ‘애저 오픈AI’는 GPT-3, 달리2(Dall-E 2), 코덱스, 임베딩 모델 시리즈를 포함해 오픈AI의 언어 모델에 대한 ‘REST API’ 접근을 제공하고 있다. 이는 콘텐츠 생성, 요약, 시맨틱 검색, 자연어에서 코드로의 번역 등을 비롯해, 다양한 특정 작업에 쉽게 적용될 수 있다.

한 대표는 그래서 “사용자는 REST API, 파이썬 SDK 또는 애저 오픈AI 스튜디오의 웹 기반 인터페이스를 통해 서비스에 접근할 수 있다.”면서 “임베딩은 텍스트의 의미론적 의미를 밀도 있게 표현한 정보로서, 현재 유사도, 텍스트 검색, 코드 검색 등 다양한 기능을 위한 세 가지 임베딩 모델 제품군을 제공하고 있다.”고 밝혔다.

그에 따르면 특히 애저는 모델의 미세 조정(파인 튜닝)을 하고 이를 호스팅하는 기능도 있다.

구글, 버텍스AI 업그레이드, ‘생성형AI 모델 구축, 커스터마이징’

구글 역시 구글 클라우드를 통해 개발자와 사용 기업, 그리고 이를 도입한 공공기관이나 정부 부처에 생성형AI를 지원한다고 발표했다. 외신을 통해 전해진 구글의 발표 내용을 보면, 크게 ▲버텍스AI의 생성형AI 지원, ▲생성형AI 앱 빌더 등 두 가지다.

버텍스AI는 머신 러닝 모델과 인공지능 애플리케이션을 학습하고 배포하기 위한 구글 클라우드의 머신 러닝 플랫폼이다. 2021년에 발표한 버텍스AI는 업그레이드를 반복한 끝에 이처럼 생성형AI를 지원하게 된 것이다. 자체 개발한 ML 모델이나 MLOps에 사용하는 것과 동일한 플랫폼에서 생성형AI 모델을 구축하거나, 커스터마이징 할 수 있다. 또한 생성형AI 앱 빌더를 사용하면 개발자가 앱이나, 채팅 인터페이스, 맞춤 검색 엔진, 디지털 비서 등 새로운 제품을 빠르게 출시할 수도 있게되었다.

이때 개발자는 구글의 기본 모델에 대한 API 액세스 권한이 주어지고, 즉시 사용 가능한 템플릿을 사용하여 몇 분 또는 몇 시간 안에 생성형 앱을 제작할 수 있다.

이 모든 과정에서 구글 클라우드는 고객 기업이나 조직이 데이터 사용 여부나, 사용 방법, 용도를 결정하고 제어할 수 있도록 보장해준다.

생성AI 기반, 콘텐츠 생성 등 위한 버텍스 AI의 ‘PaLM API’ 제공

좀더 구체적으로 보면, 개발자는 구글 클라우드를 통한 생성형AI를 활용하여 콘텐츠 생성, 채팅, 요약, 분류 등을 위해 버텍스 AI의 ‘PaLM API’에 쉽게 접속할 수 있다. 또 구글의 최신 파운데이션 모델을 선택할 수도 있다. 즉, 구글 리서치와 딥마인드에서 개발한 모델과 텍스트, 이미지, 동영상, 코드, 오디오 등 다양한 데이터 형식에 대한 지원도 있기 때문이다.

다양한 모델 중에서 선택할 수도 있다. 이를 위해 버텍스 AI는 오픈 소스나 타사 모델을 지원할 수도 있다. 즉 “다양한 모델 유형과 크기를 한 곳에서 사용할 수 있도록 함으로써 고객이 비즈니스에 가장 적합한 리소스를 유연하게 사용할 수 있도록 지원한다”는 것이다.

현재 구글 클라우드는 프롬프트를 조정하거나, 사용자 지정과 최적화하는 방법을 선택하고 있다. 즉, “비즈니스 데이터를 사용하여 기본 모델과의 관련성을 높이고 비용을 조절하면서, 데이터 주권과 개인 정보 보호를 보장한다”는 것이다.

구글 클라우드는 또 노트북, API, 대화형 프롬프트 등 다양한 도구를 통해 개발자, 데이터 과학자, 데이터 엔지니어 등이 차세대 앱과 맞춤형 모델을 구축하도록 한다. 구글은 또한 “지메일, 닥스, 슬라이드, 시트, 미트, 챗 등의 워크스페이스에서 생성AI를 협력 파트너로 진화시키겠다”고 밝힌 바 있다.

아마존, AWS 트래니엄, AWS 인퍼렌시아 출시

아마존도 지난 2월에 ‘허깅 페이스’와 생성형 AI 접근성을 높이고, 비용의 효율성을 기하기의해 협력키로 했다. 이를 통해 기존에 제공하던 ‘대규모 언어 및 비전 모델’ 학습을 위한 AWS 트래니엄(Trainium)과 추론을 위한 AWS 인퍼렌시아(Inferentia), 그리고 세이지메이커, 코드위스퍼러 등을 활용한다는 것이다.

이처럼 클라우드 서비스 사업자들은 생성형AI의 가능성에 일제히 주목하면서, 클라우드 네트워크에 이를 접목하는 다양한 방법을 구사하고 있다. 한 대표는 “앞으로 클라우드 서비스는 생성AI 기능을 제품화하고 실용화하면서, SaaS 기업들을 대상으로 치열한 경쟁을 펼칠 것”이라며 “그런 가운데 날이 갈수록 클라우드 서비스 사업자는 더 체계적이고 기능이 뛰어난 서비스를 속속 발표할 것으로 본다”고 전망했다.