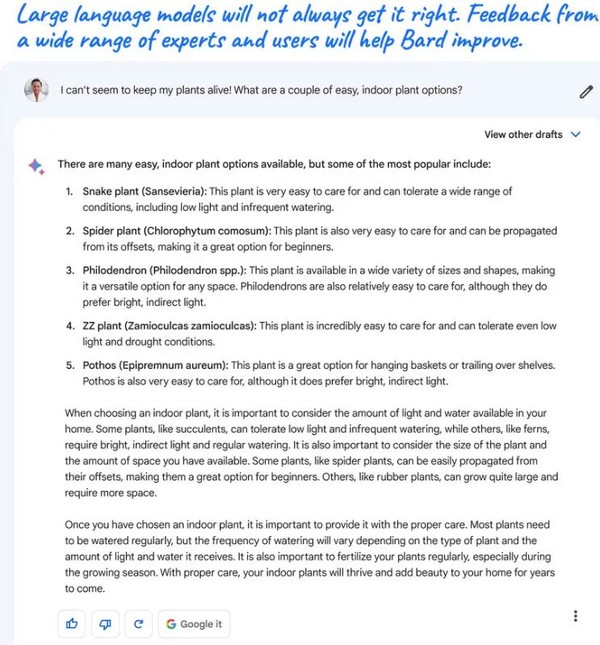

대화 내에서 각기 다른 내용의 몇 가지 답변이나 반응도 노출

데스크톱 입력 표시줄, ‘텍스트 음성 변환 기능’도 챗GPT와 차이

구글 “실험단계, 한계가 있고 항상 정답 맞출 순 없어” 경고문

[애플경제 전윤미 기자] 22일 공개된 구글 바드(Bard)는 라이벌인 챗GPT과 그 성능이 거의 비슷하거나, 서로 장․단점을 주고받는 정도의 수준인 것으로 알려졌다. 거의 모든 외신이 이를 일제히 소개할 만큼 바드는 이날 큰 관심을 끌었다.

바드는 초기엔 미국과 영국에서만 접할 수 있고, 점차 다른 나라로 대상을 늘려갈 것으로 보인다. 특히 거의 모든 외신이 이날 직접 베타 버전을 체험한 후 그 후기를 제각기 올려 눈길을 끌었다.

이들 외신이 전하는 체험 후기를 종합하면 오픈AI의 챗GPT와 함께 생성AI인 구글 바드는 인간이 만든 방대한 온라인 콘텐츠를 사용하여 응답의 과정에서 비교적 올바른 단어를 정확하게 예측하도록 훈련되었다.

많은 외신들, 실제 체험 후기 자세히 소개

NYT, 워싱턴포스트 등 유력 언론은 물론, 테크레이다, 엔가젯, 매셔블, IT프로포탈 등 기술매체들도 “지난 번보다는 많이 나아졌지만 여전히 미숙한 점이 적지 않다”는 반응이다. 일단 구글은 블로그 게시물을 통해 바드의 ‘다소 제한적인 가용성’을 발표했다. 굳이 ‘다소 제한적인’이란 수식어를 붙인 것이다.

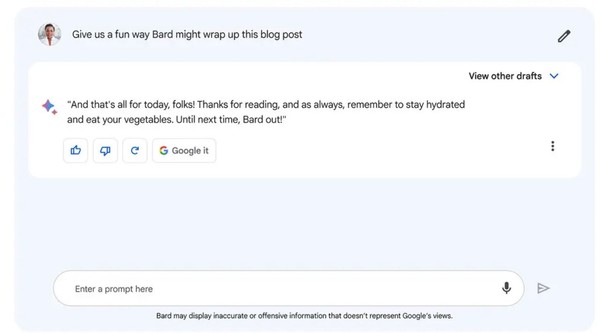

구글은 “바드를 사용하여 생산성을 높이고, 아이디어를 가속화하며 호기심을 자극할 수 있다. 사용자가 만일 올해 더 많은 책을 읽겠다는 목표를 세웠으며, 이에 도달하기 위한 조언을 바드에게 요청할 수도 있고, 양자 물리학을 간단한 용어로 설명할 수도 있고, 블로그 게시물의 개요를 설명함으로써 사용자의 창의력에 불을 붙일 수도 있다.”고 밝혔다.

프롬프트 상단에 환영 및 ‘한계’ 인정하는 경고 메시지

구글 바드는 일단 구글의 람다(LaMDA) 언어 모델(LLM)에 기반을 두고 있다. 구글측에 의하면 그러나 이는 람다의 가장 뛰어나거나 똑똑한 버전이 아니라, 일종의 ‘경량 버전’ 기반의 기술이다. 이에 구글은 “나중에 더 똑똑한 버전으로 업데이트할 것”이라고 밝힌 바 있다. 엔가젯은 “오픈AI의 GPT-3와 같은 수준인 람다는 다음 버전을 GPT-4와 같은 것을 목표하고 있다”고 분석했다.

실제 체험한 바에 따르면 바드는 챗GPT와 비슷하게 작동하는 것으로 보인다. 선택한 질문을 입력할 수 있는 ‘텍스트 프롬프트 필드’가 있는게 특징이다. 프롬프트 맨 위에는 바드가 띄운 환영 메시지가 있다. 메시지는 다음과 같다.

“저는 당신의 창의적이고 도움이 되는 협력자인 바드입니다. 저는 한계가 있고 항상 정답을 맞추지는 않겠지만, 여러분의 피드백은 제가 개선하는 데 도움이 될 것입니다.”

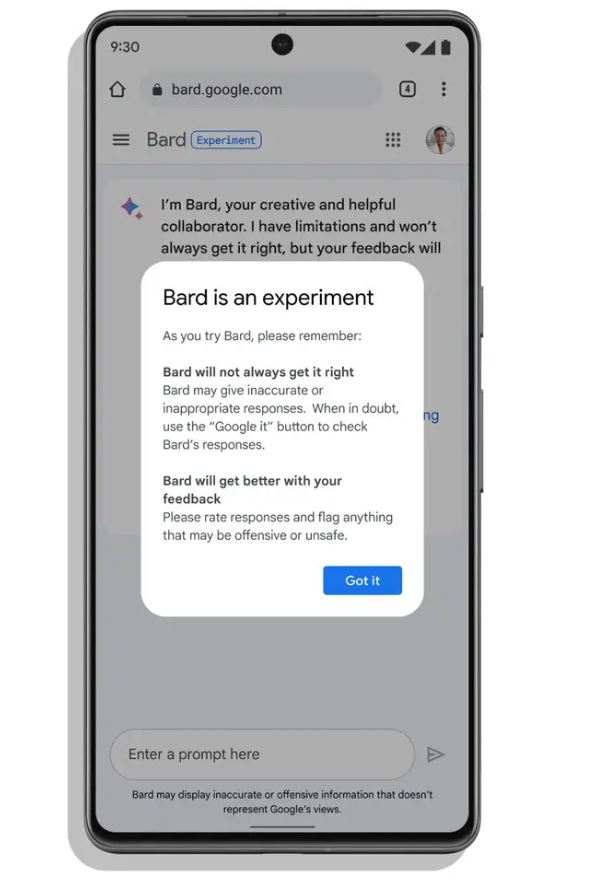

특히 구글은 이를 통해 미리 사용자들에게 바드가 결점이 없는 것은 아니라고 충고한 셈이다. 람다 언어모델(LLM)이 “부정확하고, 오해의 소지가 있거나, 거짓된 정보를 제공할 수 있다”고 경고하기도 했다.

또 웹사이트를 탐색하면 굳이 “바드는 실험단계일 뿐”이라는 경고 메시지가 뜬다. 그리곤 사용자들에게 두 가지를 기억하라고 요구한다. “바드는 항상 그것을 제대로 이해하지 못할 것”이라거나, “바드는 당신의 피드백으로 더 나아질 것”이란 얘기다.

또 ‘확인’을 클릭하고 ‘알림 메시지가 사라진 후에도 ‘텍스트 프롬프트 필드’ 아래에는 “바드가 구글의 견해를 나타내지 않는, 부정확하거나 불쾌한 정보를 표시할 수 있다.”라는 내용이 미세한 크기의 한 줄 표시가 눈에 띈다. 또 채팅을 재설정할 때마다 “바드는 아직 실험 단계에 있다. 그것과 채팅하고 반응을 평가하는 것은 경험을 향상시키는 데 도움이 될 것”이라는 내용이 뜬다.

다시 말해, 이는 바드의 불완전성을 인정하고, 사용자들이 더 많은 피드백을 해주면, 그 만큼 성능이 개선될 것이란 주문이기도 하다.

정답 외에 대화 버블 왼쪽 상단에 또 다른 선택적 답변 노출

구글 바드가 기왕의 챗GPT와 크게 다른 점은 협업을 염두에 둔 점이다. 즉, 이를 위한 기능, 한 가지 답변 뿐만 아니라 선택할 수 있는 여러 초안을 제공한다는 것이다. 그래서 결국 사용자 스스로 자신만의 AI 콘텐츠를 선택할 수 있게 한다는 취지다.

그렇다보니 바드와 MS 빙 AI의 가장 큰 차이점 역시 같은 맥락이다. 즉, 바드는 대화 내에서 하나가 아니라 다른 내용의 답변이나 반응도 볼 수 있도록 한 것이다. 각 대화 버블의 왼쪽 상단에 있는 ‘다른 초안 보기’ 옆에 있는 드롭다운 화살표를 누르면 또 다른 정답이나 선택적 답변을 볼 수 있게 했다.

물론 빙AI와 유사한 점도 있다. 화면 하단에 넓은 텍스트 입력과 대화 기반 레이아웃이 있다는 점에서 바드의 인터페이스는 빙 AI와 매우 유사하다. 하지만 그것보단 더 많은 몇 가지 중요한 차이점이 있다.

즉 Bing AI를 사용하면 채팅을 누르거나 검색 결과에서 위로 스크롤하여 대화 페이지로 이동하는 반면, 바드 웹 사이트에서는 그럴 필요가 없다. 마이크로소프트는 입력란 왼쪽에 ‘빗자루’ 아이콘이 있어 슬레이트를 지우고 새로운 주제를 시작할 수 있다. 이에 비해 바드는왼쪽에 ‘재설정 채팅’, ‘바드 활동’, ‘FAQ’, ‘도움말 & 지원’ 옵션이 있는 열이 촘촘히 들어서있다.

그런 차이점들 외에도 빙AI와 비교하여 몇 가지 기능적인 차이도 있다. 예를 들어 빙AI는 데스크톱의 입력 표시줄에 텍스트 음성 변환 기능을 제공하지 않는다. 반면엔 바드는 노트북의 마이크를 눌러 질문을 받아쓰게 할 수도 있다. 이는 말을 조리있게 잘 하지 못하는 사용자들에게 매우 편리한 기능으로 보인다.

‘복근 운동’ 질문에 부정확하고 불가능한 동작 권고도

‘엔가젯’은 실제로 바드에게 건강을 위한 ‘코어와 복근에 대한 30분 운동 계획’을 질문함으로써 그 허실을 점검해봤다. 우선 바드는 비디오를 통해 ‘다리 올리기’를 권했지만, 화면 상단에는 바드가 설명한 것과 모두 일치하지는 않는 여러 도표가 올라왔다. 실상 ‘엔가젯’ 기자의 그런 질문에 대한 가장 정확한 답변이 될 만한 내용은 이미 ‘뉴욕 타임즈’ 건강 기사에서 자세히 소개되었던 것이다.

‘엔가젯’은 “자세히 살펴보니, 여기에 있는 지침 중 일부는 말이 되지 않는다.”고 했다. ‘다리 올리기’에 대해 바드는 “무릎을 구부리고 발을 땅에 평평하게 대고 누워라. 머리 뒤에 손을 얹고 천장을 향해 다리를 올리라”고 했다. 그러나 이는 현실적으로 불가능한 자세이거나, 매우 부정확한 동작일 수 밖에 없다.

이에 빙AI와 비교하기 위해 역시 같은 운동 계획을 세워달라고 부탁했는데 “솔직히 더 나은 성적을 냈는지 판단할 수가 없다”는 결론이다. 둘다 아직은 부정확한 미완성 상태라는 얘기다.

“바드, 챗GPT, 아직은 주도권 불분명”

사실 구글은 지난 2월 마이크로소프트가 챗GPT 기반의 빙(Bing)을 출시한 날 긴급 이사회를 개최하는 등 매우 초조한 기색을 감추지 못했다. 그러다가 일주일 후 처음으로 ‘바드’ 베타 버전이 등장했으나, 이런저런 문제점이 노출되면서 아예 자취를 감췄다. 그 후 약 3주간 정도의 연구와 수정작업 끝에 이번에 나름대로 제대로 된 베타버전을 내놓은 것이다.

역시 체험 후기를 남긴 ‘뉴욕타임즈’는 “이처럼 MS와 구글의 두 제품 모두 개별적인 강점과 약점을 가지고 있으며, 현재로서는 누가 주도권을 잡을지 확실하지 않다.”면서 “다만 바드가 기반으로 하는 람다 언어 모델은 빙AI의 GPT-4만큼 대화가 가능하고 자연스럽다. 이는 구글의 오랜 음성 및 인공지능 역사를 고려할 때 놀랍지 않다.”고 했다.

현재 바드는 이미 미국과 영국의 많은 사용자들이 구매 예약을 한 상태여서, 그야말로 긴 ‘대기줄’이 이어지고 있다. 앞으로 사용자들이 바드에게 제공된 정보는 구글이 알고리즘을 미세 조정하는 데 사용된다. 그러므로 “바드에게 개인적이고 민감한 정보를 공유하지 않는 것이 중요하다”는게 전문가들의 조언이기도 하다.

다만 바드나 빙 AI와 인간 사용자들이 더 많은 이야기를 나눌수록 잠재적 편견, 차별 및 결함 있는 사고의 위험이 증가하지만, 반대로 더 나아지고 발전할 가능성도 크다는 전망이다.