AI반도체 기술 촉매, 불필요한 메모리없는 ‘경량화’로 연산속도 크게 증가

부동소수점 사례, “0.1을 0.01X10¹로 표시, 같은 소수점을 크거나 작게 표현”

메모리 대역폭에 더 많은 행렬 원소 담아, 속도와 데이터 처리량 급증

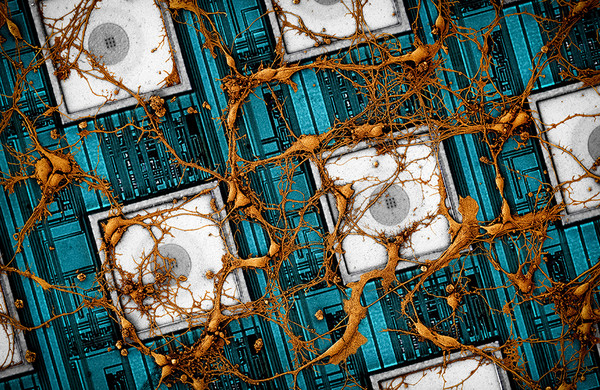

[애플경제 전윤미 기자] AI반도체가 발달하면서 효율적인 인공신경망 학습과 추론을 위해 필요한 메모리만 사용하도록 하는 ‘경량화’기술도 발전하고 있다. 그 과정에서 특히 ‘부동소수점 기반 데이터 양자화 포맷 기술’이 주목받고 있다. 이는 최대 100조개의 파라미터를 예상하는 초대형AI 시대의 또 다른 첨단 인공신경망 학습 기술이기도 하다.

이는 쉽게 말해 고정된 소수점이 아닌, 부동(浮動)소수점을 활용해, 같은 메모리 대역폭이라도 더 많은 행렬의 원소를 담게 되어, 연산 속도나 데이터 처리량을 크게 늘리는 것이다. 불필요한 데이터까지 섭렵해야 하는 기존 학습방식 대신 ‘선택과 집중’의 메모리 연산 방식으로 이해할 수 있다.

부동 소수점은 고정된 소수점을 아주 크게, 혹은 매우 작게 표현하는 방식이다. 예를 들어 고정 소수점 0.1을 밑수가 10인 부동 소수점인 0.01X10¹로 표시하는 식이다. 이는 기존의 고정 소수점 방식보다 아주 크거나 작은 수로 표현할 수 있다는게 장점이다. 그래서 이를 활용하면, 학습을 위한 천문학적 숫자의 파라미터를 크게 경량화시킬 수 있게 된다.

원활한 신경망 학습 위한 ‘피라미터 경량화’ 수단

이같은 부동소수점을 활용한 파라미터 경량화, 즉 ‘데이터 양자화 포맷’ 기술에 관한 연구결과를 소개한 김혜지 한국전자통신연구원 선임연구원은 “인공신경망의 학습에 필요한 파라미터의 양은 무수히 많고, 그 중에는 원하는 정확도 성능을 달성하는 데 거의 영향을 끼치지 않는 불필요한 학습 파라미터가 다수 포함되어 있다.”며 경량화와 ‘부동소수점 기반 데이터 포맷’의 필요성을 강조했다.

이처럼 신경망 연산을 빠르고 효율적으로 처리하면서 인식 정확도를 극대화하기 위한 방법으로 ‘부동소수점 기반 데이터 양자화 포맷’ 기술이 급속히 발전하고 있는 추세다.

이와 관련된 연구보고서 ‘AI반도체를 위한 신경망 학습용 데이터 포맷 기술동향’을 최근 정보통신기획평가원을 통해 공개한 김 선임연구원은 “이를 통한 양자화(quantization), 가지치기(pruning), 전이학습(knowledge distillation)과 같은 신경망의 효율적인 학습과 추론을 위한 경량화 연구가 활발히 진행되고 있다”고 최근의 동향을 전했다.

전자통신연구원 “32비트→8비트로 표현, 최대 16배 연산속도”

그러면서 매우 구체적인 기술 원리를 덧붙였다. 그에 따르면 흔히 AI 반도체에는 부동소수점 8bit 연산기가 추가되고 있다. 이는 신경망 양자화, 즉 원활한 학습과 추론을 위한 경량화의 일환으로 데이터 양자화 기술을 접목한 것이다. ‘부동소수점 데이터 포맷’을 통해 8비트(bit) 이하의 작은 수로 표현함으로써 신경망 학습과 추론에 필요한 메모리 사용량을 줄이는 기법이다. 이렇게 메모리가 경량화됨으로써 연산의 속도를 높이는 데이터 표현 방법이자 알고리즘이란 얘기다.

그로 인해 만약 신경망의 연산 과정, 특히 행렬 연산에서 32비트(bit)로 표현되었던 데이터를 부동소수점 8비트(bit)로 표현할 경우 같은 데이터 분량임에도 종래의 32비트와 유사한 정확도와 속도로 신경망을 학습할 수 있게되는 것이다. 같은 숫자를 크게 혹은 작게 표현할 수 있는 부동소수점 특유의 속성을 활용한 것이다.

김 선임연구원은 “행렬 연산기는 종래의 32비트 데이터 1개를 입력받을 수 있던 것에 비해, 8비트 부동소수점 데이터 포맷을 지원하면서 관련 하드웨어 연산기능을 제공하는 경우, 8비트 데이터 4개를 한 번에 입력받을 수 있다”면서 “그럴 경우 이론적으로 최대 16배까지 처리량을 상승시킬 수 있다”고 했다. 즉 “(부동소수점 데이터 포맷에 의한) 8비트 양자화(경량화) 기능은 같은 메모리 대역폭에 더 많은 행렬의 원소를 담을 수 있고, 연산기 개수가 증가하면서 시스템의 최대 처리량을 크게 높이는 효과가 있다”는 해석이다.

엔비디아․테슬라 등 실용화, 국내서도 도입

이미 글로벌 기업들도 이를 실용화하고 있는 추세다. 최근 엔비디아(NVIDIA)의 H100 GPU나, 테슬라의 ‘Dojo D1’ 칩은 바로 부동소수점 기반 8비트 연산기 등에 의한 효율적 신경망 학습과 추론 기능을 구현한 경우다.

지난해 엔비디아는 이른바 ‘저정밀도 부동소수점 8비트(FP8)’ 연산 기능을 지원하는 아키텍처 기반의 H100 GPU 칩을 공개했다. 이는 “범용 AI연구나 신경망 학습에 사용되며 2020년에 공개된 암페어(Ampere) 아키텍처의 A100 GPU 칩보다 자연어처리 모델 GPT3에서 약 6배 빠른 학습 속도를 달성했다”고 한다.

그 기술적 근원은 역시 부동소수점 원리에 기반한 것이다. 즉, 부동소수점의 ‘지수’(예를 들어 0.01X10¹의 ‘10¹’)와 가수(0.01X10¹의 ‘0.01’)의 양면 비트값에 따라 신경망은 두 가지 버전의 포맷(E4M3, E5M2)으로 구성된다. 이런 원리를 바탕으로 인공신경망의 레이어마다 데이터 표현 범위를 동적으로 조절하여, 실제 학습 과정에서 필요한 데이터 형태 변환이나 튜닝 등의 연산은 하드웨어에서 처리토록 함으로써 지연시간을 최소화하도록 한 것이다.

2021년 테슬라가 자사의 자율주행자동차를 위한 AI 반도체 Dojo D1 칩도 같은 원리에 기반하고 있다. 해당 칩은 자율주행에 필요한 인공신경망의 학습과 비디오 처리시스템에 최적화된 하드웨어 구조를 갖고 있다. 이는 역시 “부동소수점에 기반한 저정밀도 CFP8비트 데이터 포맷을 지원하여 종래의 32비트 포맷에 비해 약 16배 빠른 연산이 가능하다”는 것이다.

현재 국내에서도 AI 반도체 기업들이 이를 도입하고 있다. 퓨리오사(Furiosa)AI가 개발한 워보이(WARBOY) 칩이 대표적이다. 이는 추론 연산에서 높은 에너지 효율과 처리속도를 위해 정수형 8비트 데이터 타입을 도입하고 있어, 국내 데이터 양자화 포맷 기술 발전을 기대하게 한다.

이같은 ‘부동소수점 8비트 데이터 포맷’은 국제적으로도 표준화 움직임을 통해 공인된 첨단 기술로 자리잡고 있다. 또한 GPT 등 초대형 AI를 지향하는 현실에서 AI반도체 기술 발전의 밑거름이 될 전망이다.